Honorable and Dishonorable Mention — GeForce RTX 4090

(Image credit: Nvidia)

The RTX 4090 is conspicuously missing from this list, and there was lots of discussion behind the scenes on whether to include it or not. It’s definitely a fast GPU with great hardware behind it, but it’s also really complicated. We ended up deciding that it earns an honorable/dishonorable mention to wrap things up. It was the best of GPUs, it was the worst of GPUs…

The 4090 isn’t unlike the 980 Ti and the 1080 Ti from way back when, as it’s currently the fastest GPU for gaming by a decent margin. AMD’s competing RX 7900 XTX isn’t that far behind in raw horsepower, but the 4090 gains a massive lead in ray tracing, and DLSS is a decent bit better than FSR. Though the 4090’s performance lead is far from the blowout we saw with the 1080 Ti, it’s still just about in a class of its own.

That’s all counteracted by two highly negative attributes of the 4090 that are really hard to ignore. The whole power situation with the 4090 is unpleasant at best, with the 4090 consuming well over 400 watts and using the problematic 12VHPWR connector. Although the power plug is now discontinued and has been revised, that doesn’t change anything for the many 4090 cards out there that were made prior to the redesign. The 4090 could probably be called a disaster for this alone, as even Fermi didn’t combust.

The 4090 is also emblematic of just how expensive PC gaming has gotten in the past five years. With an MSRP of $1,600, it costs as much as a whole PC with some decent gaming hardware. Of course, the 4090 is only following the lead of the 3090 when it comes to pricing, but the 3090 was originally envisioned more as a Titan-class, luxury GPU. The RTX 3080 performed just behind the RTX 3090; the RTX 4080 is much slower than the RTX 4090.

It’s really hard to say that the 4090 is a direct line successor to the 980 Ti and 1080 Ti when it’s just so expensive. The 980 Ti and 1080 Ti were praised for how cheap they were relative to their performance, with the former costing $649 and the latter $699 at launch. Today, you can’t even find a 4090 for its already ludicrous MSRP of $1,599 — the cheapest units tend to cost $2,000 or more.

It’s already pretty obvious that the RTX 4090, though great in many ways, can’t be one of Nvidia’s greatest GPUs of all time. It just doesn’t measure up in quite the same way that its forerunners did, and that’s kind of a shame. If it didn’t have a connector liable to melt and was priced at even $1,000, it could have been the next GTX 1080 Ti. Instead, we’re still waiting for a new champion.

4 — GeForce GTX 680

(Image credit: Nvidia)

It’s rare for Nvidia to make a serious mistake, but one of its worst was the Fermi architecture. First featured in the GTX 480 in mid-2010, Fermi was not what Nvidia needed as it only offered a modest performance boost over the 200-series while consuming tons of power. Things were so bad that Nvidia rushed out a second version of Fermi and the GTX 500-series before 2010 ended, which thankfully resulted in a more efficient product.

Fermi doubtlessly caused Nvidia to do a little soul searching, and the company rethought its traditional strategy. For most of the 2000s, Nvidia lagged behind Radeon (owned first by ATI and then AMD) when it came to nodes. While newer nodes offered better efficiency, performance, and density, they were also much more expensive to use, and there were often «teething pains.» By the mid 2000s, Nvidia’s main strategy was to make big GPUs on older nodes, which often was enough to put GeForce in first place.

The experience with Fermi was so traumatic for Nvidia that the company decided that it would get to the 28nm node right alongside AMD in early 2012. Kepler, Nvidia’s first 28nm GPU, was a different chip than Fermi and prior Nvidia architectures. It used the latest process, its biggest version was relatively lean at just under 300mm2, and it offered great efficiency. The contest between the rival flagships from Nvidia and AMD was set to be very different in 2012.

Although AMD fired the first shot with its HD 7970, Nvidia countered three months later with its Kepler-powered GTX 680. Not only was the 680 faster than the 7970, it was more efficient and smaller, which were the very areas where AMD excelled with the HD 4000- and 5000-series GPUs. Granted, Nvidia only had a thin lead in these metrics, but it was rare — maybe even unprecedented — that Nvidia was ahead in all three.

Nvidia didn’t keep the performance crown for long with the arrival of the HD 7970 GHz Edition and better performing AMD drivers, but Nvidia still held the edge in power efficiency and area efficiency. Kepler continued to give AMD trouble, as a second revision powered the GTX 700-series and forced the launch of a very hot and power hungry Radeon R9 290X. True, the R9 290X did beat the GTX 780, but it was very Fermi-like, and the GTX 780 Ti took back the crown anyway.

Although not particularly well-remembered today, the GTX 680 probably should be. Nvidia achieved a very impressive improvement over the disappointing Fermi architecture using AMD’s own playbook. However, that might be because it got overshadowed by a later GPU that did the same thing but even better.

5 — GeForce RTX 3060 (12GB)

(Image credit: Tom’s Hardware)

On paper, the RTX 30-series sounded pretty good in 2020. It featured a more fleshed out architecture with improved ray tracing and tensor cores, it offered tons more raw performance, and it even returned to an attractive pricing structure. In practice, retail pricing was nowhere near where it should have been. It was hard to find a 30-series GPU at anything close to MSRP — or any graphics card of the time, for that matter.

Nevertheless, in the months following the launch of the 30-series in late 2020, Nvidia continued to add new models to the lineup, working its way down the performance stack. The midrange was particularly important, as the prior RTX 20-series with its RTX 2060 and 2060 Super weren’t exactly amazing follow ups to the GTX 1060. Given that anyone would buy a GPU with a pulse in 2021, Nvidia didn’t really have to put much effort into a new GPU, but it surprised everyone with the RTX 3060.

Nvidia doesn’t always nail its midrange offerings, but the RTX 3060 was a great exception. It was significant step up from the RTX 2060 in performance, and most notably had double the VRAM at 12GB. That was more VRAM than even the regular RTX 3080 with its 10GB (though there was a 3080 12GB that wasn’t really available). Such a big improvement gen-on-gen was pretty remarkable for Nvidia. (We should also note that we’re not including the gimped RTX 3060 8GB in this discussion.)

(Image credit: Nvidia)

What was even more remarkable was how AMD’s competing midrange cards, which were normally quite potent, weren’t all that powerful. The RX 6600 and 6600 XT had decent horsepower but only 8GB of VRAM, had to rely on inferior FSR 1.0 upscaling instead of DLSS, and came out months later. AMD competed pretty well against the rest of the 30-series and usually had a VRAM capacity advantage, but the Navi 23 cards were the exception.

Of course, the GPU shortage was a thing, and the RTX 3060 wasn’t immune — even with Nvidia’s first «self-owned» attempt at locking out Ethereum mining. Eventually the shortage subsided in 2022, and that made the 3060 one of the most affordable GPUs. The 3060 never quite reached its MSRP of $329, while the 6600 and 6600 XT both fell well below $300 in time. Additionally, FSR 2.0 offered quality and performance improvements that made it more competitive with DLSS, further reducing the 3060’s advantage.

Still, the RTX 3060 stands as one of Nvidia’s best midrange GPUs ever. Beyond pricing and availability issues, it was a great card that certainly gave AMD a run for the money. It was also uniquely good among the rest of the 30-series, which was almost always way too expensive and/or paired with not nearly enough VRAM to make much sense. It’s a pity the RTX 4060 threw most of that progress away.

Возможные технические характеристики новых видеокарт от Nvidia

GeForce RTX

Релиз новых видеокарт от Nvidia может состояться уже в первых месяцев 2024 года. Согласно инсайдеру Kopite7kimi, компания выпустит четыре видеокарты, которые будут рассчитаны под современные задачи:

- GeForce RTX 4070 Super;

- GeForce RTX 4070 Ti Super;

- GeForce RTX 4080 Super;

- GeForce RTX 4090 Ti.

Согласно утечке, до релиза 40-й серии Nvidia GeForce версии «Супер» осталось несколько недель. Учитывая вышесказанную информацию, нас ждут сразу 3 видеокарты с пометкой «Super». GeForce RTX 4080 Super будет иметь графический процессор AD103 в его полной конфигурации с 10 240 ядрами CUDA. Также Nvidia планирует релиз GeForce RTX 4070 Ti Super и GeForce RTX 4070 Super. По слухам, GeForce RTX 4070 Ti Super получит графический процессор Nvidia AD103 с 48 Мб кэш-памяти L2 и 16 ГБ 256-разрядной подсистемы памяти GDDR6X, что значительно повысит производительность этой видеокарты по сравнению с оригинальной моделью RTX 4070 Ti.

Возможные технические характеристики новинок от Nvidia:

| Название | GPU | FP32 CUDA Cores | Кэш L2 |

| GeForce RTX 4090 Ti | AD102 | 18 176 | Нет информации |

| GeForce RTX 4080 Super | AD103 | 10 240 | 64 Мб |

| GeForce RTX 4070 Ti Super | AD103 | 8 448 | 48 Мб |

| GeForce RTX 4070 Super | AD104 | 7 168 | 48 Мб |

Предполагается, что GeForce RTX 4080 SUPER будет иметь 20 Гб памяти GDDR6X или 16 Гб памяти GDDR6X. Ожидается, что GeForce RTX 4070 SUPER будет иметь 12 Гб памяти GDDR6X.

Стоит учитывать, что вся информация является неточной и, возможно, GeForce RTX 4070 Ti Super и GeForce RTX 4070 Super даже могут не появиться в продаже.

Nvidia откажется от обычных RTX 4080

GeForce RTX 4080

На технических форумах в Китае появился слух, что Nvidia готовится к прекращению продаж обычной видеокарты RTX 4080. Из-за появившейся информации некоторые китайские продавцы начали массово закупать RTX 4080 перед завершением выпуска видеокарт компанией.

В ближайшее время на место Nvidia RTX 4080 может прийти GeForce RTX 4080 Super, которая получит 20 Гб памяти. Инсайдер Kopite7kimi сообщает, что это будет действительно прекращение продаж прошлой версии видеокарты, однако Nvidia просто выпустит технологическое обновление, как это было с RTX 2080 и RTX 2080 Super.

2 — GeForce 8800 GTX

(Image credit: FritzchensFritz)

The early 2000s saw the emergence of modern graphics cards as both Nvidia and ATI made progress in crucial areas. Nvidia’s GeForce 256 introduced hardware accelerated transform and lighting visuals, while ATI’s Radeon 9700 Pro revealed that GPUs should pack more computational hardware and could be really big. When Nvidia took a big loss at the hands of the 9700 Pro in 2002, it really took that lesson to heart and began making bigger and better GPUs.

Although ATI had started the arms race, Nvidia was dead set on winning it. Both Nvidia and ATI had made GPUs as large as 300mm2 or so by late 2006, but Nvidia’s Tesla architecture went up to nearly 500mm2 with the flagship G80 chip. Today, that’s a pretty typical size for a flagship GPU, but back then it was literally never-before-seen.

Tesla debuted with the GeForce 8800 GTX in late 2006, and it delivered a blow to AMD not far off of what the Radeon 9700 Pro did to Nvidia just four years prior. Size was the deciding factor between the 8800 GTX and ATI’s flagship Radeon X1950 XTX, which was almost 150mm2 smaller. The 8800 GTX was super fast, as well as pretty power hungry for the time, so you also have the 8800 GTX to thank for normalizing GPUs with 150+ watt TDPs — even if that seems pretty quaint nowadays.

Although ATI was the one to invent the BFGPU, it couldn’t keep up with the 8800 GTX. The HD 2000-series, which only got as large as 420mm2, couldn’t catch up to the G80 chip and Tesla architecture. ATI instead changed tactics and began to focus on making smaller, more efficient GPUs with greater performance density. The HD 3000-series flagship HD 3870 was surprisingly small at just under 200mm2, and the following HD 4000- and 5000-series would follow with similarly small die sizes.

More recently, Nvidia tends to follow up powerful GPUs with even more powerful GPUs to remind AMD who’s boss, but back then Nvidia wasn’t quite like that. The Tesla architecture was so good that Nvidia decided to use it again for the GeForce GTX 9000-series, which was pretty much the GeForce 8000 series with a slight performance bump. Granted, the 9800 GTX was almost half the price of the 8800 GTX, but it still made for a boring GPU.

Although the 8800 GTX is pretty old now, it’s remarkable how modern it is in other ways. It had a die size consistent with today’s high-end GPUs, it used a cooler with aluminum fins, and it had two 6-pin power connectors. It only supported up to DirectX 10, which didn’t really go anywhere, so it can’t really be used for modern gaming, but otherwise it’s very recognizable as a modern GPU.

3 — GeForce GTX 980

(Image credit: Future)

From the emergence of the modern Nvidia versus AMD/ATI rivalry in the early 2000s to the early 2010s, both GeForce and Radeon traded blows generation after generation. Sure, Nvidia won most of the time, but usually ATI (and later AMD) weren’t far behind; the only time where one side was totally beaten was actually when ATI’s Radeon 9700 Pro decimated Nvidia’s GeForce 4 Ti 4600. However, Nvidia came pretty close to replicating this scenario a couple of times.

By the mid-2010s, the stars must have aligned for Nvidia. Semiconductor foundries around the world were having serious issues getting beyond the 28nm node, including Nvidia’s and AMD’s GPU manufacturing partner TSMC. This meant that Nvidia could get comfortable with its old strategy of making big GPUs on old nodes without worrying about AMD countering with a brand-new node. Additionally, as AMD was risking bankruptcy, it effectively had no resources to compete with a wealthy Nvidia.

These two factors coinciding at the exact same time made for the perfect storm. Nvidia had already done a very respectable job with the Kepler architecture with the GTX 600- and 700-series, but the brand-new Maxwell architecture for the GTX 900-series (and the GTX 750 Ti) was something else. It squeezed even more performance, power efficiency, and density out of the aging 28nm node.

(Image credit: Future)

The flagship GTX 980 wiped the floor with both AMD’s R9 290X and Nvidia’s own last-gen GTX 780 Ti. The GTX 980 was faster, more efficient, and smaller, but unlike the 680, the 980’s leads were absolutely massive in these regards. The 980 was nearly twice as efficient as the 290X, performed about 15% or so faster, and shaved off nearly 40mm2 in die area. Compared to the 780 Ti, the 980 was almost 40% more efficient, about 10% faster, and had a die size over 160mm2 smaller.

This wasn’t a victory quite on the level of the Radeon 9700 Pro, but it was massive all the same. It was essentially on par with what AMD did to Nvidia with the HD 5870. Except, instead of responding with a bad GPU, AMD had nothing to throw back at Nvidia. All AMD could do in 2014 was hang on for dear life with its aging Radeon 200-series.

In 2015, AMD tried its best to compete again, but only at the high-end. It decided to refresh the Radeon 200-series as the Radeon 300-series from the low-end to the upper midrange, and then use its brand-new Fury lineup for the top-end. Nvidia however had an even bigger Maxwell GPU waiting in the wings to cut AMD’s hopeful R9 Fury X off, and the GTX 980 Ti did exactly that. With 6GB of memory, the 980 Ti became the obvious choice over the 4GB-equipped Fury X (which was actually a decent card otherwise).

Though a great victory for Nvidia, the GTX 900-series permanently altered the landscape of gaming graphics cards. The Fury X was AMD’s last competitive flagship until the RX 6900 XT in 2020, and that was largely because AMD stopped making them every generation. AMD is back to regularly making flagship GPUs (knock on wood), but Maxwell really mauled Radeon and it didn’t recover for many years.

GeForce RTX 4000 – технические характеристики

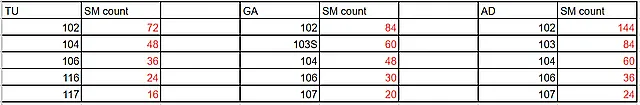

Утечки, источником которых является проверенный информатор kopite7kimi, предполагают, что графический чип AD102 может иметь структуру ядра 12×6 (для сравнения, ядро Ampere GA102 – 7×6). Таким образом, полноценный чип NVIDIA Lovelace будет иметь 12 блоков GPC (кластер обработки графики), 72 блока TPC (кластер обработки текстур) и 144 блока SM (потоковых мультипроцессоров).

В результате это даёт целых 18 432 ядра CUDA. На фоне AD102 полноценный GA102 выглядит довольно скромно – «всего» 84 блока SM и 10752 ядра CUDA, что почти в два раза меньше. У GeForce RTX 3090 их ещё меньше, потому что в основе лежит немного урезанный графический чип с 10496 шейдерами.

Если GeForce RTX 4090 будет работать на полной версии AD102, её (частичные) характеристики будут следующими:

Как может выглядеть спецификация GeForce RTX 4090

- Архитектура: NVIDIA Lovelace

- Графическая система: AD 102

- Площадь ядра AD102: около 600 мм2

- Литография: 5 нм TSMC

- Количество ядер CUDA: 18 432

- Тип памяти: GDDR6X

- Шина данных: 384-битная

- Производительность FP32: 81 TFLOPS (на частоте 2200 МГц)

- Тактовая частота ядра (в режиме Boost): 2200-2500 МГц

-

Энергопотребление (TGP):

420-450 Вт850 Вт (!)

Тем не менее, в спецификациях самого мощного (или любого другого) чипа NVIDIA Lovelace ещё предстоит заполнить множество пробелов. Вы должны быть терпеливы и ждать новых утечек.

Инсайдер Greymon55 подтвердил предыдущие предположения, и флагманская модель RTX 4090 должна быть оснащена памятью GDDR6X с 384-битной шиной. Так что эта часть спецификации останется нетронутой по отношению к RTX 3090. С одним очень важным отличием – NVIDIA, вероятно, будет использовать более быстрые планки (выше 20 000 МГц) с пропускной способностью, превышающей 1000 ГБ/с.

Спецификации NVIDIA Lovelace – огромная порция кеша L2

Хакеры из группы Lapsus$, похитившие данные с серверов NVIDIA, опубликовали не только исходный DLSS, но и название следующего, после Хоппера, поколения (Blackwell). Благодаря утечке мы узнали первые подробности о спецификациях других графических чипов NVIDIA Lovelace. Они подтверждают предыдущие утечки о ядре AD102. Пришло время взглянуть на них, поскольку они выглядят многообещающе.

Ядро AD103, которое, скорее всего, будет использоваться в мобильных версиях топовой RTX 4000 и, возможно, RTX 4070 (Ti), должно иметь такое же количество ядер CUDA, как и самый большой чип серии Ampere – GA102.

Обязательно обратите внимание на огромный объём кеша L2. Это гигантский скачок по сравнению с RTX 3000, у которого было 2-6 МБ (!)

Без расширений.

Посмотрите на спецификации остальных графических ядер NVIDIA Lovelace.

Спецификация AD102 (RTX 4090, RTX 4080Ti и RTX 4080):

- Количество блоков GPC: 12

- Количество блоков TPC: 72

- Количество блоков СМ: 144

- Количество ядер CUDA: 18 432

- Кэш L2: 96 МБ

- Шина памяти: 384-битная

Спецификация AD103 (RTX 4070/Ti, мобильные RTX 4080 и RTX 4080 Ti):

- Количество блоков GPC: 7

- Количество блоков TPC: 42

- Количество блоков СМ: 84

- Количество ядер CUDA: 10 752

- Кэш L2: 64 МБ

- Шина памяти: 256-битная

Спецификация AD104 (RTX 4070 и RTX 4060 Ti):

- Количество блоков GPC: 5

- Количество блоков TPC: 30

- Количество блоков СМ: 60

- Количество ядер CUDA: 7680

- Кэш L2: 64 МБ

- Шина памяти: 256-битная

Спецификация AD106 (RTX 4060):

- Количество блоков GPC: 3

- Количество блоков ТПК: 18

- Количество блоков СМ: 36

- Количество ядер CUDA: 4608

- Кэш L2: 48 МБ

- Шина памяти: 192-битная

Спецификация AD107 (RTX 4050, RTX 4050 Ti):

- Количество блоков GPC: 3

- Количество блоков ТПК: 12

- Количество блоков СМ: 24

- Количество ядер CUDA: 3072

- Кэш L2: 32 МБ

- Шина памяти: 128-битная

Новые видеокарты от AMD

AMD Radeon RX 7000

В то время как Nvidia уже представила на рынке значительную часть своих видеокарт, AMD все еще держит в рукаве многие из своих потенциальных продуктов. Пока доступны только три модели текущего поколения (RX 7900 XTX, RX 7900 XT и RX 7600)

Информация о многих новых картах была случайно слита компанией AMD в мае, как сообщает (Tom»s Hardware). Следующие графические процессоры еще могут появиться:

- Radeon RX 7950 XTX:Карта высокого класса, вероятно, должна использовать топовый GPU Navi 31, возможно, это обновление уже выпущенной RX 7900 XTX. Как (Igor»s Lab)подозревает, конкретных планов по выпуску карты может и не быть — она может служить лишь временной прокладкой на случай появления необходимости в более мощных продуктах.

- Radeon RX 7950 XT:В принципе, к видеокарте применимо то же самое, что и к ее старшей сестре — только по отношению к RX 7900 XT.

- Radeon RX 7900 GRE:По данным утечки (@momo_us)high-end карта будет выпущена в июле — но, вероятно, только в Китае. Предполагается, что карта будет очень похожа на уже выпущенную RX 7900 XT, но объем памяти уменьшен до 16 Гбайт и предлагается только 256-разрядная шина. Взамен энергопотребление снижается до 300 Вт, о чем (Sven Bauduin из PCGH)сообщает.

- Radeon RX 7800 XT:Согласно утечке информации от AMD, в RX 7800 XT будет использоваться графический процессор Navi-32. Кроме того, карта должна иметь 16,0 Гбайт памяти GDDR6, о чем Leaker (@harukaze5719)сообщал в июне. Это совпадает с заявлениями о том, что закон Мура умер, приведенными ниже. Он по-прежнему ожидает карту с 16,0 Гбайт памяти, которая также будет иметь 70 вычислительных блоков и TBP в 260 Вт.

AMD Radeon RX 8000

Как и в случае с RTX 5000 от Nvidia, слухи вокруг RX 8000 пока очень скудны. Среди прочего, предполагается переход на новую архитектуру RDNA 4, изготавливаемую по техпроцессу N3 компании TSMC.

Кроме того, предполагается, что топовая модель, возможно, RX 8900 XTX, будет предлагать (полные 18 432 шейдера). Также ожидается новая архитектура памяти в виде GDDR7 и PCIe 5.0.

Однако все это пока отдельные голоса, некоторые из которых предсказывают очень большой скачок — например, в количестве шейдеров. Поэтому к этим данным следует относиться с дополнительной долей недоверия.

С точки зрения времени это может произойти к 2025 году, как и в случае с Nvidia, учитывая, как долго AMD сдерживает выпуск новых видеокарт RX-7000.

Arc Alchemist и Alchemist+

Выпустив Arc Alchemist, компания Intel заявила о себе и на рынке игровых карт. И для дальнейшего присутствия на нем производитель, видимо, планирует разместить новые видеокарты до конца этого года.

К примеру, уже анонсированная, но так и не появившаяся модель A580, слухи о которой появились в конце июля. При ожидаемой цене около 200 евро он может стать интересной альтернативой для бюджетных геймеров.

Другие видеокарты от Intel, вероятно, являются обновлением уже выпущенных карт под названием Alchemist+. Ожидаются две карты с энергопотреблением от 75 до 100 и от 175 до 225 Вт соответственно.

Intel может показать видеокарты во время своего инновационного мероприятия в сентябре, а релиз может состояться в 2023 году.

Arc Battlemage

Второе поколение видеокарт компании Intel под кодовым названием Battlemage ожидается не ранее 2024 года. Это следует из утечки внутренней дорожной карты (RedGamingTech)от марта.

Согласно ей, здесь также планируется выпуск в две волны. Сначала карты, обозначенные какG10

должны заменить модели A580, A750 и A770 во втором квартале 2024 года. В третьем квартале на смену G21 придут графические процессоры начального уровня A310 и A380.

В Battlemage Intel собирается сосредоточиться в первую очередь на сегментахPerformance

иEnthusiast

. Они также хотят продолжить оптимизацию существующей архитектуры и добиться прогресса, особенно в ускорении трассировки лучей.

Arc Celestial и Druid

До третьего и четвертого поколения видеокарт Intel еще очень далеко. Не стоит ожидать появления соответствующих моделей раньше 2025 года

До этого времени даже к утечкам информации о видеокартах следует относиться более скептически, чем обычно, поскольку в процессе разработки еще многое может измениться

Доступность новых видеокарт в России

GeForce RTX 4090 Ti

До момента официального старта продаж (или хотя бы официального анонса от Nvidia) довольно тяжело говорить о доступности технологических новинок на территории России. Тем более, после недавних заявлений, что США запретила поставку графических ускорителей A100, A800, H100, H800, L40 и L40S, а также игровых видеокарт GeForce RTX 4090 в Китай и ряд других стран, включая Российскую Федерацию. На фоне данной новости в Китае начали дорожать графические ускорители.

Стоит также отметить, что компания Nvidia официально прекратила поставки графических ускорителей в Россию ещё в 2022 году, однако импортёры новинок продолжают завозить видеокарты, как и другую технику через страны СНГ и Китай.

Архитектура NVIDIA Lovelace вместо Hopper

Прежде чем перейти к сути, небольшое пояснение, ведь планы – обсуждавшиеся только в кулуарах – претерпели значительные изменения. По первым – уже устаревшим – слухам, следующее поколение видеокарт NVIDIA, после Ampere, должно было называться Hopper – по имени Грейс Хоппер (1906-1992), математик, относящаяся к числу основателей компьютерных наук.

По неофициальным данным, архитектура Hopper дебютирует позже и претерпит революционные изменения. Она будет основана на многомодульной структуре, называемой MCM (Multi-Chip Module). Чиплетная структура (несколько более мелких чипов, соединенных вместе) не является чем-то новым – она успешно используется в ЦП, например, в процессорах AMD Ryzen. Это позволяет увеличить выход продукции и снизить себестоимость, а значит и конечную цену продукта.

Ещё не время для технологии чиплета

Однако, прежде чем произойдёт желанная многими пользователями революция, нам нужно будет получить видеокарты, основанные на традиционной, монолитной архитектуре, которая должна быть «всего лишь» эволюцией. Они будут производиться с использованием 5-нанометровой литографии, что позволит увеличить плотность размещения транзисторов. Именно в этом технологическом измерении создаются видеокарты NVIDIA GeForce RTX 4000.

По неподтвержденной информации, после Ампера в стане зеленых наступит царство архитектуры NVIDIA Lovelace, названной в честь Ады Лавлейс (1815-1852), дочери поэта Джорджа Байрона. Она была математиком, широко известным как первый программист в истории. Одним из величайших успехов «мастера кодирования девятнадцатого века» стало создание первой компьютерной программы. Она разработала алгоритм для нужд неполной аналитической машины английского математика Чарльза Бэббиджа, которого некоторые называют отцом информатики.

Поэтому, когда мы будем прощаться с чипами Ampere (GA102, GA104, GA106), мы будем приветствовать Lovelace (AD102, AD104, AD106).

NVIDIA Ada Lovelace на 5 нм – Samsung или TSMC

До сих пор было непонятно, будет ли NVIDIA использовать техпроцесс Samsung или TSMC. Но Greymon55, известный утечками информации о новых архитектурах AMD RDNA 3, а также NVIDIA Hopper и NVIDIA Lovelace, рассказал, чего ожидать. Судя по всему, проект последней уже завершен, а значит – никаких изменений она не увидит (это не относится к спецификациям отдельных моделей из серии GeForce RTX 4000).

Архитектура NVIDIA Lovelace должна производиться в технологическом измерении 5 нм TSMC, поэтому системы GeForce RTX 3000 (а не RTX 3000 Super, которые «похоронили») станут последними, произведенными Samsung. Сомнительно, будет ли это литография N5 или её улучшенная версия N5P. Выбор последней приведёт к повышению эффективности (на 7%) и снижению энергопотребления (до 15%). Это не значит, что GeForce RTX 4000 будет «кушать» мало электроэнергии – совсем наоборот.

GeForce RTX 4000 – какой блок питания

В первых сообщениях хорошо осведомленных информаторов, таких как kopite7kimi и Greymon55, флагманские модели GeForce RTX 4000 должны были иметь энергопотребление свыше 400 Вт. Прогнозировалось, что, например, GeForce RTX 4090 будет иметь TGP 420-450 Вт. Это существенный скачок по сравнению с RTX 3090, у которого энергопотребление составляет 350 Вт. Блоки питания мощностью выше 1000 Вт могут стать нормой с премьерой видеокарт на базе архитектуры NVIDIA Lovelace.

В начале 2022 года прогнозы взлетели до небес… Энергопотребление GeForce RTX 4090 не 450, 500, 600 и даже не 700 Вт. Greymon55 и kopite7kimi слышали из своих источников, что флагман серии RTX 4000 будет иметь аппетит в… 850 Вт (!). Это значение только видеокарты. Для такой GPU блока питания на 1000 Вт будет недостаточно…

Энергопотребление RTX 4080 и RTX 4080 Ti – огромный аппетит к электричеству

Энергопотребление младших моделей говорит о том, что различия в производительности между другими видеокартами на базе чипа AD102 могут быть достаточно большими.

До сих пор графические процессоры с этих полок предлагали (очень) схожее энергопотребление:

- Потребляемая мощность GeForce RTX 4080Ti – 650 Вт (прирост на 300 Вт по сравнению с RTX 3080 Ti)

- Потребляемая мощность GeForce RTX 4080 – 450 Вт (увеличение на 130 Вт по сравнению с RTX 3080)

Эти значения кажутся абсурдными (разве что для RTX 4080), но если посмотреть на энергопотребление RTX 3090 Ti (450 Вт), которое столкнулось с лагами на пути к своей премьере, оно уже не кажется таким уж невероятным. . С большой (вычислительной) мощностью приходит столь же большой аппетит к электричеству… Kopite7kimi не уверен в этих значениях (50 из 50). Можно мечтать о 450 Вт в RTX 4090 Ti, но есть большая вероятность, что это будут не 850 Вт, а ближе к 650-750 Вт.

Это означает, что NVIDIA намерена использовать графический чип AD102 на пределе возможностей, вероятно, для конкуренции с Radeon RX 7000, которые должны иметь чиплетную структуру и, по слухам, более высокую производительность. В условиях такой конкуренции такое высокое энергопотребление (к сожалению) имеет смысл.