Технические характеристики

| GPU | AD102 |

| Число транзисторов | 76,3 млрд. |

| Техпроцесс | 5 нм |

| Площадь кристалла | 608,3 мм² |

| Число FP32 ALU | 16384 |

| Число блоков SM | 128 |

| Тензорные ядра | 512 |

| RT ядра | 128 |

| Базовая частота | 2230 МГц |

| Частота буста | 2520 МГц |

| Объем памяти | 24 Гб |

| Тип памяти | GDDR6X |

| Шина памяти | 384 бит |

| Частота памяти (эффективная) | 21000 MHz |

| Пропускная способность памяти | 1008 Гбайт/с |

| TDP | 450-600 Вт |

| Ядра для трассировки лучей | 3-е поколение |

| Тензорные ядра | 4-е поколение |

| NVIDIA DLSS | 3 |

| PCI Express | Gen 4 |

| Энкодер NVIDIA (NVENC) | 2x 8-го поколения |

| Декодер NVIDIA (NVDEC) | 5-е поколение |

| Кодирование AV1 | Да |

| Декодирование AV1 | Да |

Значения базовой частоты, частоты буста и TDP зависят от схемотехники, которую использует тот или иной вендор: ASUS, Palit и др. Разгонный потенциал по частоте видеочипа и видеопамяти будет зависеть от их удачности. Увеличенное значение TDP и частот влияет на стоимость видеокарты, иногда существенно, но это не всегда означает, что видеочип и память возьмут максимально возможные частоты при разгоне. Вероятно, это даст немного свободнее работать видеокарте, при этом разница может составлять порядка 4-6 процентов, а при попадании на отборный образец может доходить до 10 процентов.

Будем стараться упоминать в статье диаметр вентиляторов, чтобы мы имели понятие, на какой видеокарте больший воздушный поток при аналогичной скорости вращения. Конечно, на поток, а также создаваемое давление влияет количество лопастей, их профиль, но для точного выяснения того, какое количество лопастей и их профиль дают максимальную производительность, необходимо отдельное тестирование, поэтому будем опираться на более доступные параметры.

У каждой площадки, обозревающей ту или иную видеокарту, имеется свой тестовый стенд, который может быть в виде корпуса, открытого стенда; температуры будут упоминаться, но учтите, что в вашем случае они могут быть несколько иными. Это всё необходимо для того, чтобы мы могли оценить, какая система охлаждения будет производительнее. Максимальная граница температур для видеочипа немного сдвинулась и теперь находится на 84 градусах, что больше на 2 градуса в сравнении с прошлым поколением. Расширенные лимиты по TDP теперь позволяют поднять планку только до 88 градусов (вместо 92 как раньше). Исходя из данного ограничения, производители видеокарт могут сделать такую систему охлаждения, которая будет упираться в температурный лимит в 82 градуса. Достаточной же температурой для повседневной работы чипа может быть значение в 72-76 градусов. Если значение будет ниже, то ещё лучше. Системы охлаждения флагманского уровня позволяют охладить видеочип до 62-66 градусов и ниже. Чем нам поможет знание о текущих температурах видеокарты? Если карта будет стоять до замены на более новую, то температуры особой роли не играют, если же хочется получить более долгоживущую и тихую карту, то лучше присмотреться к производительным системам охлаждения.

Видеокарта также фиксирует температуру HOT SPOT или температуру самой горячей точки. В большинстве случаев, особенно с воздушными системами охлаждения, она будет выше, чем температура видеочипа. Минимальная разница между HOT SPOT и видеочипом говорит о качестве системы охлаждения и используемых термоинтерфейсов. На данную разницу мы опираться не будем по причине того, что температура самой горячей точки может быть вплоть до 110 градусов, что даже при слабом охлаждении и лимите температур для видеочипа в 82 градуса не даст упереться температуре HOT SPOT в свой предел.

Кроме температуры самой горячей точки будем смотреть на температуры памяти. Лимит по температурам памяти находится в пределах 110 градусов. Более качественная система охлаждения позволит держать температуру чипов на более низком уровне. В данном случае у нас 12 чипов памяти по 2 Гб.

Также обратим внимания на уровни шума видеокарт. Конечно, они получены в разных условиях, но дадут нам некоторое представление о шуме видеокарты под нагрузкой. Без нагрузки мы не будем сравнивать по причине технологий FAN STOP, когда вентиляторы совсем не работают или же у некоторых производителей вращаются на низких оборотах

Для понимания величины шума обратите внимание на картинку ниже:

Ещё раз стоит повторить, что условия для замеров у разных площадок, где выкладывают обзоры — разные. Это только примерный ориентир, он даст понять, как хорошо охлаждается видеокарта, как быстро вращаются вентиляторы и на чём производитель всё же сэкономил.

DLSS 3 tested

DLSS has been a superstar feature for RTX GPUs for the past few generations, but DLSS 3 is a major shift for the tech. It introduces optical flow AI frame generation, which boils down to the AI model generating a completely unique frame every other frame. Theoretically, that means even a game that’s 100% limited by the CPU and wouldn’t see any benefit from a lower resolution will have twice the performance.

That’s not quite the situation in the real world, but DLSS 3 is still very impressive. I started with 3DMark’s DLSS 3 test, which just runs the Port Royal benchmark with DLSS off and then on. My goal was to push the feature as far as possible, so I set DLSS to its Ultra Performance mode and the resolution to 8K. This is the best showcase of what DLSS 3 is capable of, with the tech boosting the frame rate by 578%. That’s insane.

Jacob Roach / Digital Trends

In real games, the gains aren’t as stark, but DLSS 3 is still impressive. Nvidia provided an early build of A Plague Tale: Requiem, and DLSS managed to boost the average frame rate by 128% at 4K with the settings maxed out. And this was with the Auto mode for DLSS. With more aggressive image quality presets, the gains are even higher.

A Plague Tale: Requiem exposes an important aspect of DLSS 3, though: It incurs a decent amount of overhead. DLSS 3 is two parts. The first part is DLSS Super Resolution, which is the same DLSS you’ve seen on previous RTX generations. It will continue to work with RTX 20-series and 30-series GPUs, so you can still use DLSS 3 Super Resolution in games with previous-gen cards.

Image used with permission by copyright holder

DLSS Frame Generation is the second part, and it’s exclusive to RTX 40-series GPUs. The AI generates a new frame every other frame, but that’s computationally expensive. Because of that, Nvidia Reflex is forced on whenever you turn on Frame Generation, and you can’t turn it off.

If you reason through how Frame Generation works, it should provide double the frame rate of whatever you’re getting with just Super Resolution, but that’s not the case. As you can see in Cyberpunk 2077 below, the Frame Generation result means that the GPU is only rendering about 65 frames — the rest are coming from the AI. With Super Resolution on its own, that result jumps up by nearly 30 fps. That’s the DLSS Frame Generation overhead at play.

Image used with permission by copyright holder

Obviousy, Frame Generation provides the best performance, but don’t count out Super Resolution as obsolete. Although it would seem that Frame Generation doubles DLSS frame rates, it’s actually much closer to Super Resolution on its own in practice.

You can’t talk about DLSS apart from image quality, and although DLSS 3 is impressive, it still needs some work in the image quality department. Because every other frame is generated on the GPU and sent straight out to your display, it can’t bypass elements like your HUD. Those are part of the generated frame, and they’re ripe for artifacts, as you can see in Cyberpunk 2077 below. The moving quest marker sputters out as it moves across the screen, with the AI model not quite sure where to place pixels as the element moves. Normally, HUD elements aren’t a part of DLSS, but Frame Generation means you have to factor them in.

Image used with permission by copyright holder

That same behavior shows up in the actual scene, as well. In A Plague Tale: Requiem, for example, you can see how running through the grass produces a thin layer of pixel purgatory as the AI struggles to figure out where to place the grass and where to place the legs. Similarly, Port Royal showed soft edges and a lot of pixel instability.

Image used with permission by copyright holder

These artifacts are best seen in motion, so I captured a bunch of 4K footage at 120 fps, which you can watch below. I slowed down the DLSS comparisons by 50% so you can see as many frames as possible, but keep in mind YouTube’s compression and the fact that it’s difficult to get a true apple-to-apples quality comparison when capturing gameplay. It’s best to see in the flesh.

RTX 4090 Gameplay and DLSS 3 showcase

While playing, the image quality penalties DLSS 3 incurs are easily offset by the performance gains it offers. But Frame Generation isn’t a setting you should always turn on. It’s at its best when you’re pushing ray tracing and all of the visual bells and whistles. Hopefully ,it will improve, as well. I’m confident Nvidia will continue to refine the Frame Generation aspect, but at the moment, it still shows some frayed edges.

Слухи о дате выхода rtx 4090

Некоторые источники утверждают, что релиз rtx 4090 может произойти в ближайшие несколько месяцев. Предполагается, что NVIDIA продолжит свою традицию выпуска новых графических карт каждые два года, что означает, что релиз rtx 4090 может состояться примерно в 2023 году.

Однако, другие слухи говорят о возможном задержании выхода rtx 4090. Предполагается, что задержка может быть вызвана различными факторами, такими как проблемы с производством, сложности в разработке или даже конкуренция на рынке. Это означает, что релиз rtx 4090 может произойти позже, чем ожидалось.

Не стоит забывать, что это всего лишь слухи, и NVIDIA пока не делала официальных заявлений касательно даты выхода rtx 4090. Лучшим подходом будет следить за официальными новостями и анонсами от NVIDIA, чтобы быть в курсе последних обновлений и подтвержденной информации.

Независимо от конечной даты релиза, rtx 4090 безусловно вызывает большой интерес и ожидание у любителей высокой графики и игровых компьютеров. Среди фанатов NVIDIA накопилось множество ожиданий, и надеемся, что компания не подведет своих поклонников и выпустит настоящий монстр инноваций в ближайшее время.

Инсайдерские данные о дате выхода rtx 4090

Инсайдеры, близко связанные с индустрией, предлагают свои прогнозы относительно выхода нового RTX 4090. Несмотря на то, что официальная информация пока не была анонсирована, есть несколько интересных инсайдов.

По информации, которую удалось получить от источника, близкого к разработчикам, дата выхода RTX 4090 запланирована на вторую половину 2022 года. Этот прогноз связан с тем, что компания Nvidia всегда стремится удивить своих пользователей и предложить что-то новое и инновационное.

Будущие обладатели RTX 4090 смогут насладиться сверхпроизводительностью и уникальными возможностями, которыми будет обладать самая ожидаемая графическая карта года. Разработчики активно работают над совершенствованием архитектуры и увеличением производительности, чтобы предложить своим пользователям непревзойденный опыт игры и работы с графикой.

Конечно, сроки могут измениться, ведь пока информация находится в стадии слухов и спекуляций. Но fans & tech enthusiasts будут ждать с нетерпением официального заявления от компании Nvidia о дате выхода нового процессора графики и надеяться, что он превзойдет все ожидания.

Неофициальные источники о дате выхода rtx 4090

Хотя официальная информация о дате выхода rtx 4090 от Nvidia еще не была представлена, появилось несколько неофициальных слухов и утечек, которые намекают на возможную дату релиза.

Одним из таких источников является инсайдерская информация, которую опубликовал известный в геймерском сообществе источник. Согласно его данным, Nvidia планирует представить новую серию графических карт rtx 4090 во втором квартале 2022 года.

Другой неофициальный источник утверждает, что Nvidia выйдет с новыми видеокартами rtx 4090 уже в начале следующего года. Этот источник ссылается на внутреннюю информацию в компании и публикует предполагаемую дату выхода в первом квартале 2022 года.

Однако важно отметить, что все эти сведения основаны на неофициальных источниках и требуют подтверждения от Nvidia. Компания Nvidia держит подробности о своих новых продуктах в секрете до официального анонса, поэтому фанатам придется подождать официальных данных о релизе rtx 4090

Зачем нужен счетчик фпс в CS GO?

Счетчик фпс отображает количество кадров, которые отображаются на экране каждую секунду. Чем выше значение фпс, тем плавнее отображается игра. Если фпс слишком низкий, например, ниже 60 или 30, игра может замедляться и возникают лаги, что влияет на точность ведения огня и реакцию на действия противников.

С помощью счетчика фпс игроки могут отслеживать показатели производительности своего компьютера и оптимизировать настройки игры. Если фпс ниже желаемого значения, игроки могут уменьшить графические настройки, отключить некоторые эффекты или внести изменения в конфигурационные файлы игры для улучшения производительности.

Счетчик фпс также полезен для тестирования новых оборудований или обновлений драйверов. Он позволяет игрокам оценить, какие изменения влияют на производительность игры и принять решения об обновлении компонентов или настроек.

В итоге, счетчик фпс является неотъемлемым инструментом для игроков в CS GO, помогающим оптимизировать настройки и достичь наилучшей производительности в игре.

Как убрать ограничение фпс

Ограничение FPS можно отключить в панели управления NVIDIA.

Нужно перейти в раздел Параметры 3D — Управление параметрами 3D.

Вертикальный синхроимпульс установить на — Выключено.

Отключение вертикальной синхронизации в панели управления Nvidia

Иногда наблюдается ограничение FPS игры во весь экран, когда в оконном режиме ограничений нет. Поэтому нужно отключить оптимизацию игры во весь экран.

Для этого кликаем правой кнопкой мыши — по значку запуска игры и выбираем свойства.

Заходим в свойства GTAVLauncher

В свойствах открываем вкладку — Совместимость. Ставим галочку — отключить оптимизацию во весь экран.

Отключить оптимизацию во весь экран

RTX 4090 Ti будет не похож ни на один другой графический процессор, когда-либо выпущенный

Не так давно игровое сообщество было поражено тем, на что способна Nvidia RTX 4090. Карта превосходит аналог последнего поколения с огромным отрывом. Даже RTX 4080 намного медленнее флагмана Team Green.

Ожидается, что аналогичная история будет рассказана с грядущей RTX 4090 Ti. Хотя у нас нет тонны информации о будущих чипах, просочившиеся спецификации намекают на гораздо более быструю видеокарту.

Ожидаемая дата выпуска

Подробностей о RTX 4090 Ti немного, и Nvidia еще не выпустила несколько карт, прежде чем объявит что-либо об этом грядущем бегемоте.

RTX 3090 Ti была выпущена через год и квартал после того, как 3090 вышла на рынок. Таким образом, вполне вероятно, что до усовершенствованного GPU на базе AD102 еще далеко.

Тем не менее, мы можем ожидать, что чип будет запущен в последнем квартале 2023 года. Компания выпустит графические процессоры серии RTX 4070 и RTX 4060 до появления 4090 Ti.

Более того, графический процессор начального уровня класса 50 может отодвинуть 4090 Ti обратно на CES 2024. Маловероятно, что Team Green перейдет к своему следующему самому быстрому предложению до того, как линейка Ada Lovelace будет полностью запущена.

Характеристики

Основываясь на просочившихся спецификациях, перечисленных на TechPowerUp, 4090 Ti будет основан на графическом процессоре AD102, таком как RTX 4090. Будущий графический процессор будет содержать 18 176 ядер CUDA, что на 10,9% больше, чем у RTX 4090.

Будущая видеокарта будет содержать 568 блоков отображения текстур (TMU), 192 блока вывода рендеринга (ROP), 142 потоковых мультипроцессора и 142 ядра RT.

Помимо увеличения количества ядер, RTX 4090 Ti будет поставляться с более быстрой памятью, способной обеспечить еще более высокую пропускную способность. Графический процессор будет содержать 24 ГБ памяти GDDR6X с пропускной способностью 24 Гбит/с, и эта повышенная скорость повысит пропускную способность памяти до 1152 ГБ/с.

Спецификации грядущей RTX 4090 Ti были сопоставлены с RTX 4090 в таблице ниже.

| Nvidia GeForce RTX 4090 | Nvidia GeForce RTX 4090 Ti | |

| имя графического процессора | AD102 | AD102 |

| CUDA-ядра | 16 384 | 18 176 |

| TMU | 512 | 568 |

| ROP | 176 | 192 |

| Смс | 128 | 142 |

| Базовые частоты | 2235 МГц | 2355 МГц |

| Разгон | 2520 МГц | 2625 МГц |

| Размер памяти | 24 ГБ | 24 ГБ |

| Тип памяти | 21 Гбит/с GDDR6X | 24 Гбит/с GDDR6X |

| Пропускная способность памяти | 1008 ГБ/с | 1152 ГБ/с |

| Расчетная мощность | 450 Вт | 800 Вт |

Первоначальные утечки предполагали, что 4090 Ti будет иметь максимальную TDP 800 Вт. Однако после того, как 4090 был запущен с TDP 450 Вт, маловероятно, что вариант Ti будет иметь такое высокое энергопотребление.

RTX 4090 Ti станет следующим крупным продуктом на рынке потребительских вычислений на GPU. Видеокарта будет намного быстрее, чем любые другие предложения на данный момент.

How does the RTX 4090 stack up?

There really is no denying that the RTX 4090, the vanguard of the coming fleet of Ada Lovelace GPUs, is a fantastically powerful graphics card. It’s ludicrously sized, for sure, which helps both the power delivery and thermal metrics. But it’s also a prohibitively priced card for our first introduction to the next generation of GeForce GPUs.

Sure, it’s only $100 more than the RTX 3090 was at launch, and $400 less than the RTX 3090 Ti, which could even make it the best value RTX 40-series GPU considering the amount of graphics silicon on offer. But previous generations have given the rest of us PC gamers an ‘in’ to the newest range of cards, even if they later introduced ultra-enthusiast GPUs for the special people, too.

But the entire announced RTX 40-series is made of ultra-enthusiast cards, with the cheapest being a third-tier GPU—a distinctly separate AD104 GPU, and not just a cut-down AD102 or AD103—coming in with a nominal $899 price tag. Though as the 12GB version of the RTX 4080 doesn’t get a Founders Edition I’ll be surprised if we don’t see $1,000+ versions from AIBs at launch.

That all means no matter how impressed I am with the technical achievements baked into the Ada Lovelace architecture—from the magic of DLSS 3 and Frame Generation, to the incredible clock speed uptick the TSMC 4N process node delivers, and the sheer weight of all those extra transistors—it’s entirely limited to those with unfeasibly large bank accounts.

And, at a time of global economic hardship, it’s not a good look to only be making your new architecture available to the PC gaming ‘elite’.

(Image credit: Future)

Nvidia will argue there is silicon enough in the current suite of RTX 30-series cards to cater to the lower classes, and that eventually, more affordable Ada GPUs will arrive to fill out the RTX 40-series stack in the new year. But that doesn’t change the optics of this launch today, tomorrow, or in a couple of months’ time.

Which makes me question exactly why it’s happening. Why has Nvidia decided that now is a great time to change how it’s traditionally launched a new GPU generation, and stuck PC gamers with nothing other than an out-of-reach card from its inception?

Do the Ada tricks not seem as potent further down the stack? Or is it purely because there are just so many RTX 3080-and-below cards still in circulation?

I have a so-far-unfounded fear that the RTX 4080, in either guise, won’t have the same impact as the RTX 4090 does, which is why Nvidia chose not to lead with those cards. Looking at the , particularly the comparisons between the 16GB and 12GB RTX 4080 cards and their RTX 3080 Ti and RTX 3080 12GB forebears, it reads like the performance improvement in the vast majority of today’s PC games could be rather unspectacular.

Both Ada GPUs have fewer CUDA cores, and far lower memory bandwidth numbers, compared with the previous gen cards. It looks like they’re relying almost entirely on a huge clock speed bump to lift the TFLOPS count, and the magic of DLSS 3 to put some extra gloss on their non-RT benchmarks.

In a way it might seem churlish to talk about fears over the surrounding cards, their GPU make up, and release order in a review of RTX 4090. I ought to be talking about the silicon in front of me rather than where I’d want it to exist in an ideal world, because this is still a mighty impressive card from both a gen-on-gen point of view and from what the Ada architecture enables.

(Image credit: Future)

I said at the top of the review there’s nothing subtle about the RTX 4090, but there is a level of finesse here to be applauded. The RT Core improvements take us ever further along the road to a diminished hit when enabling the shiny lighting tech, and the Tensor Cores give us the power to create whole game frames without rendering.

Seriously, DLSS with Frame Generation is stunning.

I’m sure there will be weird implementations as developers get to grips (or fail to get to grips) with enabling the mystical generative techniques in their games, where strange visual artefacts ruin the look of it and create memes of their own, but from what I’ve experienced so far it looks great. Better than 4K native, in fact.

And while the $1,600 price tag might well be high, it is worth noting that spending big on a new generation of graphics cards is probably best done early in its lifespan. I mean, spare a thought for the people who bought an RTX 3090 Ti in the past seven months. For $2,000. They’re going to be feeling more than a little sick right now, looking at their overpriced, power-hungry GPU that is barely able to post half the gaming performance of this cheaper, newer card.

It feels somewhat akin to the suffering of Radeon VII owners once the RX 5700 XT came out. Only more costly.

Как посмотреть статистику прослушиваний на Яндекс Музыке

Для того чтобы посмотреть статистику прослушиваний на Яндекс Музыке, нужно перейти на вкладку Инфо. Для того, чтобы узнать количество слушателей за полгода, нужно нажать значок в блоке «Количество слушателей за». Также есть функция, которая поможет увидеть, в каком месяце за полгода пользователи активнее добавляли исполнителя в список любимых. Для этого нужно нажать значок в блоке «Количество лайков за». Таким образом, на Яндекс Музыке можно отслеживать статистику слушателей и лайков и узнать, когда именно публика была наиболее активной. Эта информация может быть полезной для музыкантов и менеджеров, чтобы лучше понимать вкусы своей аудитории.

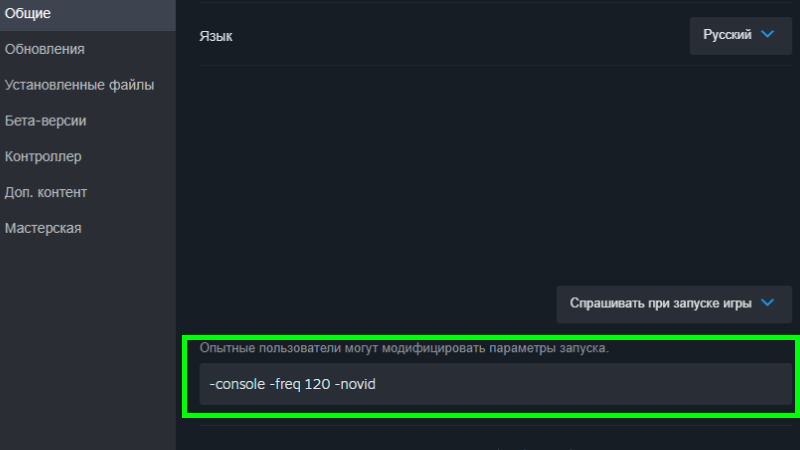

Как повысить FPS с помощью команд запуска?

К сожалению, но какие-то параметры запуска просто не работают в КС2, а какие-то перестали работать из-за более современных Windows. Посмотрим, что можно сделать и чего делать не нужно.

Сперва открываем эти самые параметры. Они находятся по такому пути:

- Steam.

- Библиотека игр. Ищем CS2.

- Кликаем по ней правой кнопкой мыши. Потом на «Свойства».

- Открывается окно с меню справа. Никуда не нажимаем, так как мы уже в нужном пункте «общие».

- Листаем немного вниз и кликаем пустую строчку.

Вводить будем в эту строчку

Команды

Для слабого компьютера вводятся следующие команды:

+cl_showfps 1 -novid -threads 6 -high -freq 60 -refresh 60 -tickrate 128 -noforcemparms -dxlevel 81 -noaafonts -heapsize 1048576

Каждая команда отвечает за определенный процесс в системе компьютера, а также при запуске игры, например:

- -novid — отключает анимацию загрузки. Ресурсы ПК на неё не тратятся.

- -high — важная команда. Она делает КС2 приоритетнее всех остальных процессов в системе. Проще говоря, все свободные ресурсы компьютера будут стимулировать работу игры. Правда, на современных ПК приоритет итак отдается игре…

- -freq 60 и -refresh 60 — две команды, которые ставят ФПС не выше 60-ти. Подойдет для мониторов с герцовкой до 59 и 60.

- -dxlevel 81 — включает DirectX 8.1.

- -noaafonts — выключает сглаживание шрифтов.

С другими параметрами запуска можно ознакомиться вот тут.

Как повысить ФПС в КС2

Для повышения FPS в CS2 можно воспользоваться разными способами. Лучше вообще нормально так подготовить и ПК, и игру, и видеокарту и всё для комфортной игры. Приступаем.

Да, что это такое?

Что такое ФПС

FPS (Frames Per Second) — это сменяемость кадров в секунду. Измеряется в числовом эквиваленте, считая частоту в секунду. Проще говоря, если у вас 50 ФПС, то вы видите 50 кадров в секунду, что не является лучшим показателем.

Если ваш ФПС слишком мал (ниже 30), то играть будет трудно. Почти невозможно. Если же выше 60-ти, то вы не заметите ни одного лага и фриза. Пока кадры снова не упадут до 30.

Хорошо, если FPS пусть и не запредельный, но стабильный. Если ПК вытаскивает 80 кадров, но при это не дотягивает до 90, но и не падает до 59, то это замечательно. А вот если в игре FPS 90, но при раскрытии смоков он падает до 30, то это уже плохо.

Лучше стабильнее, чем иногда много

Почему ФПС в CS2 так важен

Вопрос имеет место быть. FPS никак не влияет на то, каким игроком вы будете. Потому что умение — это навык. А навык тренируется и приходит с опытом. Чем больше играете и тренируетесь, тем вы круче. Если коротко.

Можно даже с ботами побегать в Бой Насмерть, но главное — тренироваться

Если FPS постоянно низкий, то тренить нормально не получится. Все клатчи будут проигрываться, а удовольствия от игры не будет совсем. Можно сказать, что от показателя кадров зависит и любовь к CS2. Чем меньше кадров, тем меньше любви.

Какое значение ФПС считается оптимальным

Такое, на котором вам удобно играть. Но если вы играли на 50-60 кадрах, а потом прыгнули на 100-200 без повышения герц у моника, то разницы будет мало. Потому что просто будут стабильные 60. А вот с новой герцовкой, да. Разница будет огромной.

Удобно может быть и на 100, а может быть неудобно на 240. Давайте посмотрим ключевые значения:

Так сколько?

До 30 — плохо. Картинка будет фризить, противник будет услышан вами, однако умрете вы быстрее, чем заметите его. Играть на таком параметре не рекомендуется.

30-40 — приемлемо, но не рекомендуется. Если вы решили поиграть с таким FPS в соревновательном режиме, то учтите — один фриз в важный момент, и вы отдадите раунд противникам.

40-55 — хороший показатель. На таком уровне можно играть соревновательные игры, однако на высоких званиях, где часто используются гранаты, есть риск, что ваш FPS просядет до 20-30 кадров в секунду.

55-60 и выше — отличный показатель. Для игроков, у которых монитор 59-60 gH — 60 FPS будет просто плавной картинкой без лагов и фризов. Если ваш компьютер с трудом дотягивает до 60-ти frames per second, то стоит воспользоваться дополнительными настройками, чтобы во время взрыва смоков и молотовых игра не тормозила.

Тестовый стенд

RTX 4080 у нас в исполнении Palit GameRock OmniBlack. Раз Nvidia сравнивает новинку с 3080 Ti, то и мы также поступим. Она у нас в схожем исполнении Palit GameRock. Заодно посмотрим, насколько лучше 4090 MSI Suprim X с её 68%-м превосходством в количестве ядер и блоков. За процессорную производительность в ответе стоковый i9-12900K с DDR5 в XMP 7200 МГц CL34. Остальные комплектующие перед вами.

- Процессор: Intel Core i9-12900K

- Материнская плата: MSI MEG Z690i Unify

- Оперативная память: DDR5 TEAMGROUP DELTA RGB Black 32GB (2x16GB) 7200MHz CL34-42-42-84 1.4V

- Видеокарта #1: Palit GeForce RTX 4080 GameRock OmniBlack

- Видеокарта #2: Palit GeForce RTX 3080 Ti GameRock

- Видеокарта #3: MSI GeForce RTX 4090 Suprim X

- Блок питания: DeepCool PQ1000M

- Охлаждение: NZXT Kraken Z63

- Корпус: BC1 Open Benchtable

- Операционная система: Windows 11

Шаг 1: Подготовьте свою систему

Прежде чем приступить к разгону RTX 4090, необходимо убедиться, что ваша система к этому готова. Вот несколько вещей, которые вы должны сделать:

• Обновите драйверы: убедитесь, что у вас установлены последние версии драйверов Nvidia для вашего RTX 4090. Вы можете загрузить их с веб-сайта Nvidia или использовать GeForce Experience для автоматического обновления.

• Обновите BIOS: убедитесь, что у вас установлена последняя версия BIOS для вашей материнской платы. Вы можете проверить версию своего BIOS, войдя в меню настройки BIOS (обычно нажав F2 или Del во время загрузки) или используя утилиту, такую как CPU-Z. Вы можете загрузить последнюю версию BIOS с веб-сайта производителя вашей материнской платы и следовать их инструкциям по ее обновлению.

• Подключите кабели питания: Для работы RTX 4090 требуется много энергии, поэтому вам нужно убедиться, что к нему подключено достаточное количество кабелей питания. RTX 4090 Founders Edition поставляется со специальным адаптером, который позволяет подключать четыре 8-контактных кабеля питания PCIe от вашего блока питания. В качестве альтернативы вы можете использовать один кабель 12VHPWR, если ваш блок питания поддерживает его. Убедитесь, что все кабели надежно подключены, не ослаблены и не погнуты.

• Проверьте охлаждение: разгон увеличит тепловыделение вашего графического процессора, поэтому вам нужно убедиться, что у вас достаточно охлаждения для него. RTX 4090 Founders Edition оснащен кулером с тремя вентиляторами, которого должно быть достаточно в большинстве случаев, но вы также можете использовать специальный контур водяного охлаждения или воздушный охладитель вторичного рынка, если хотите повысить производительность охлаждения. Вы также должны убедиться, что в вашем корпусе хороший воздушный поток и вентиляция, а также очистить вентиляторы и радиаторы от пыли и мусора.

• Резервное копирование данных: разгон иногда может привести к сбоям или повреждению данных, поэтому всегда полезно создать резервную копию важных данных, прежде чем начинать изменять настройки графического процессора. Для резервного копирования файлов можно использовать внешний жесткий диск, облачный сервис или программное обеспечение для резервного копирования.

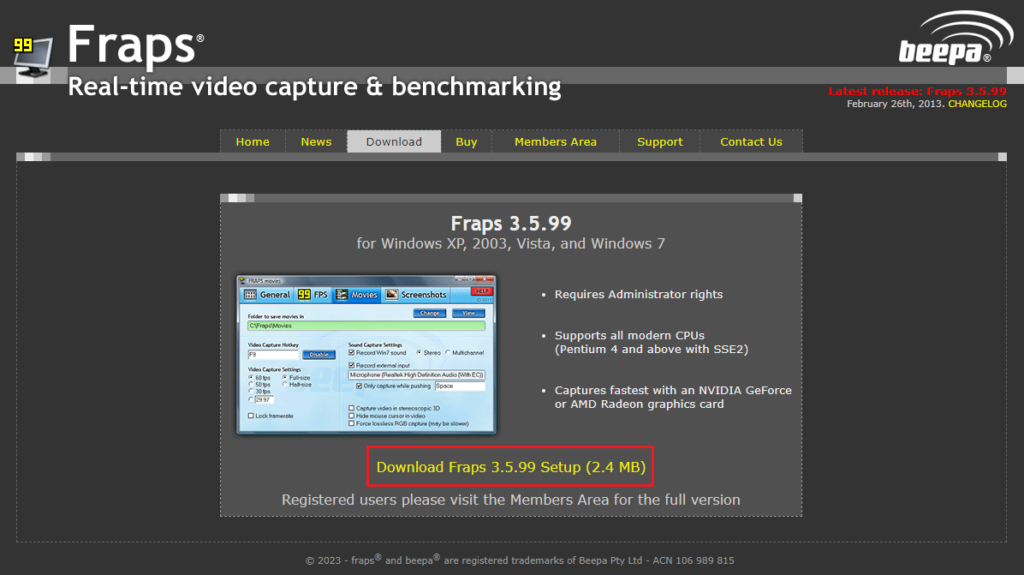

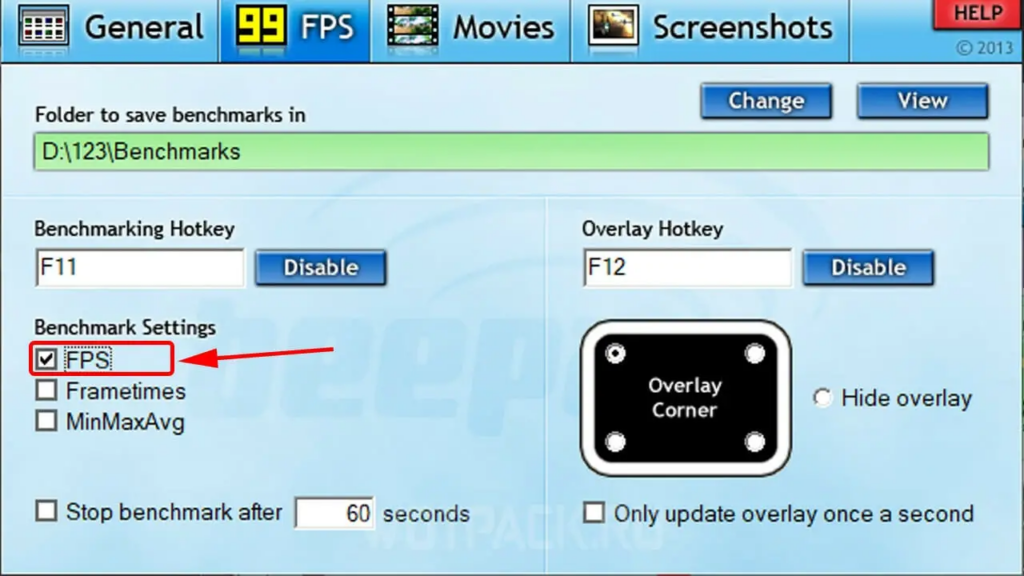

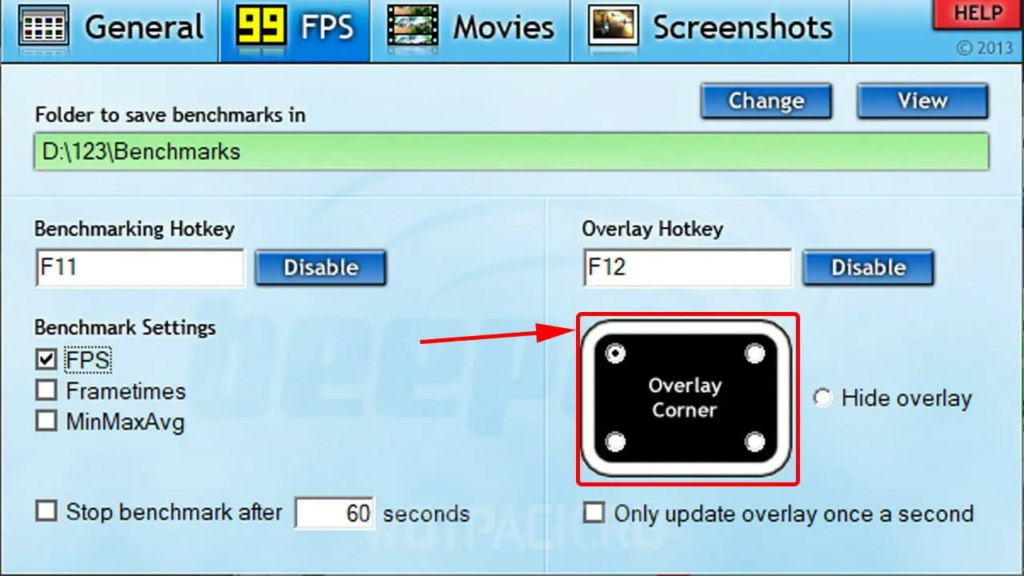

Как включить фпс в CS 2 через программы для мониторинга

Рассмотрим на примере как включить FPS в CS 2 через программу мониторинга Fraps:

Скачайте фрапс с официального сайта разработчика.

Запустите ПО через ярлык на рабочем столе или меню «Пуск».

Проверьте, чтобы напротив пункта «FPS» стояла отметка, если ее нет – поставьте.

Выберите удобный для вас вариант отображения счетчика FPS.

После проделанных действий вы можете запускать игру – в КС 2 будет показывать счетчик ФПС, пока включена программа Fraps.

Весь эти вышеперечисленные программы и не только, которые мониторят производительность в играх, могут конфликтовать по неизвестным причинам с CS 2.

В большинстве случаев, решить проблему помогает добавление команды в параметры запуска «-allow_third_party_software». Чуть выше уже рассказывалось, как .

Польза от использования счетчика фпс

Счетчик фпс полезен по нескольким причинам:

- Оптимизация настроек. Используя счетчик фпс, вы можете определить, насколько хорошо работает ваше оборудование и настроить графические параметры игры соответствующим образом. Если фпс слишком низкий, то вам следует снизить графическую настройку игры для более плавного и комфортного геймплея. Счетчик фпс позволяет вам наблюдать динамику изменений в производительности игры.

- Обнаружение проблем. В процессе игры счетчик фпс может помочь выявить различные проблемы, такие как неправильная работа видеокарты, перегрев компонентов или отсутствие основного процессорного времени. Если у вас внезапно падает фпс, это может сигнализировать о проблеме, которую стоит решить для лучшей производительности игры.

- Контроль качества. Счетчик фпс позволяет контролировать качество отображения игры. Вы можете следить за фпс, чтобы увидеть, как различные графические настройки влияют на производительность. Также, с помощью счетчика фпс вы можете сравнивать производительность разных конфигураций оборудования или настроек игры.

В общем, использование счетчика фпс – это полезный инструмент, который помогает оптимизировать и улучшить производительность игры, а также выявить и решить возможные проблемы, которые могут влиять на игровой процесс.